在大数据行业,经常把数据比作石油。长远来看,数据的战略价值不亚于石油,人工智能时代来临之后,相信每个人都能感受到这一点。

石油作为能源物资,尚有部分替代品;而数据,几乎意味着未来数字世界的生存规则。人类生老病死、衣食住行、工作消费、政治文化经济生活等活动都将被数据影响和控制,说统治也不为过。

把数据比作石油,还因为它们有相似的价值提炼过程。

石油从最初原油经过加工,提炼出汽油、柴油,进而合成塑料、橡胶等产品。

数据由原始的形态,经过加工,也会像石油一样有广泛的用途。

但并不是每个人都能说清楚数据能用来做什么,产生什么价值,大部分人可能只有一个模糊的印象。我想通过本文,使大家对大数据的典型应用有更进一步的了解。

1、主数据

狭义的主数据是指多个系统中高度复用的那类数据。当同一个数据在多个系统中存在的时候,主数据的问题就产生了。

举个例子,你收到了本月的工资,银行卡会有一条入账记录。同时,你又有记账的良好习惯,需要在记账软件中手动把工资收入的数字记录进去(除非你不怕隐私泄露,将银行卡交易信息授权给记账软件使用),完成两个数据的同步。如果记错了,很可能这个月的账对不上。这就是主数据的典型问题。银行卡交易数据,对个人来说就是主数据。

主数据是个人和组织价值较高的稳定数据。在多个系统中存在,也体现了它的重要性,所以它还被称为黄金数据。

最早的主数据问题,首先在企业中产生。一家公司,会有很多业务系统,比如 OA 办公系统、财务系统、CRM 客户管理系统、ERP 进销存系统等,如果是一家大型的集团公司,每个子公司同类业务的系统也可能不同。这就造成了同类数据如员工、供应商、客户等,在各个系统中不同步,这会造成业务延迟,甚至统计出错。

主数据本质是拥有数据的主体,保有一致性数据的问题。

个人、公司、政府都会受到这个问题的挑战。常说的数据孤岛,一方面是讲数据锁定在局部,不发生流通,另一方面,是讲同一份数据,不能保持一致性。

主数据的概念出现的非常早,大约 20 年前,IBM 就提出了概念、问题和方法。直到今天,这个问题也解决的不是十分完美。这里面的问题非常多,最重要的有几点:

- 如何确定是同一个数据?

- 数据以哪个系统为准(具体到字段级别)?

- 如何及时同步给其它系统,遇到冲突怎么办?

政务数据共享交换开放,从广义上讲,也属于主数据的范畴,属于国家对政府各部门所拥有的高价值数据的定义、识别与分发。

在日常生活中,我们都已经享受到国家持续解决这个问题所带来的红利。比如异地检车、一网通办等各类便民业务。

在主数据应用领域中,更重要的是数据技术。如使用统一标识(One ID)技术去定位唯一数据,变化数据捕捉(CDC)技术及时发现变动的数据,数据同步技术完成数据的分发等。

2、搜索

这里主要是指全文检索。

首先谈谈大家日常使用频率最高的大数据应用——搜索引擎。

百度的网络蜘蛛在全网抓取网页内容,将爬取的网页快照存储在自己的服务器上。毫无疑问,这是真正的大数据。

为了给用户返回精确的结果,接下来还有两件事情。首先是关键词和网页的匹配,其次是搜索结果的排序。

网页的内容,通过分词的手段,将内容打散,判断各词汇的密度,大体猜测出这篇内容讲得是哪方面的内容。这是传统搜索引擎主要做的工作,现代则应用了更多 NLP(自然语言处理)的技术,使程序“阅读”文本内容后“总结中心思想”更为精确。这里主要解决搜得准。

关键词和相关网页建立联系,就是索引,技术上也通过索引的优化,使得搜索结果能在毫秒级返回,这里很考验技术,既需要考虑相同关键词的索引数据尽可能分区集中,避免跨节点的读取延时,又需要考虑多并发(每天几十亿次查询)随机读的性能。这里主要解决搜得快。

搜索引擎另一大核心任务是对结果排序,按关键词密度给网页确定权重的方式,相对低级,内容生成者也容易作弊。排序本质是结果的精确度和内容价值的权重计算。如何靠机器判断内容的价值高低?Google 创建 PR 算法的假设是一个网页被其它网页引用的次数越多,该网页价值就越大,类似于评估论文的重要性的方法是统计它被引用的次数;另外也可以根据结果列表被点击的间隔时间来判断,如果第一个结果条目被点击后,很多人都又很快点击第二个条目,表明第一个结果质量不太高,并不是用户所需要的,系统就会逐步降低第一个条目的权重。类似的判断逻辑会有很多。

搜索引擎也在向个性化搜索结果的方向演进,判断用户的特征,呈现不一样的搜索结果。

明白了搜索引擎的原理,就很容易理解另一种大数据应用——舆情监控系统。可以理解为将有限数量的关键词的搜索结果自动汇总,再按情感聚类,最简单按正面的、负面的聚类,按负面的级别向用户告警。

除此之外,如法律文书的检索,或其它海量文本的检索,底层都是全文检索的技术引擎。著名的大数据组件 Elasticsearch 正是为此而生。

以提交关键词的方式,从海量文本中精确命中结果,是大数据的第二大类应用。

3、查询

这里主要指即席查询(Ad Hoc),又称为交互式查询。

提到交互式,程序员比较容易理解这个词,在命令行终端里,输入命令或程序语句,回车后系统马上能返回结果,这称为交互式环境。Node.js、Python 都提供了这样的交互式编程环境。

即席查询也是同样的道理,用户在界面上选择查询的条件、范围,或输入 SQL 语句,提交后立即可以获得查询结果。

和上面第二类全文检索核心不同之处在于查询所输入的内容不同,一种是灵活的文本关键词,另一种可以理解为 SQL 语句。理论上来讲,即席查询的数据比全文检索数据结构化程度更深,查询的命令也更为精确,相对更为容易。

但真的更容易吗?在数据量小的情况下,确实很容易,如果是单库单表查询,即使再复杂的SQL,加上比较耗性能的去重计数 count(distinct) 类的统计,也会在很短时间内获得正确的结果。

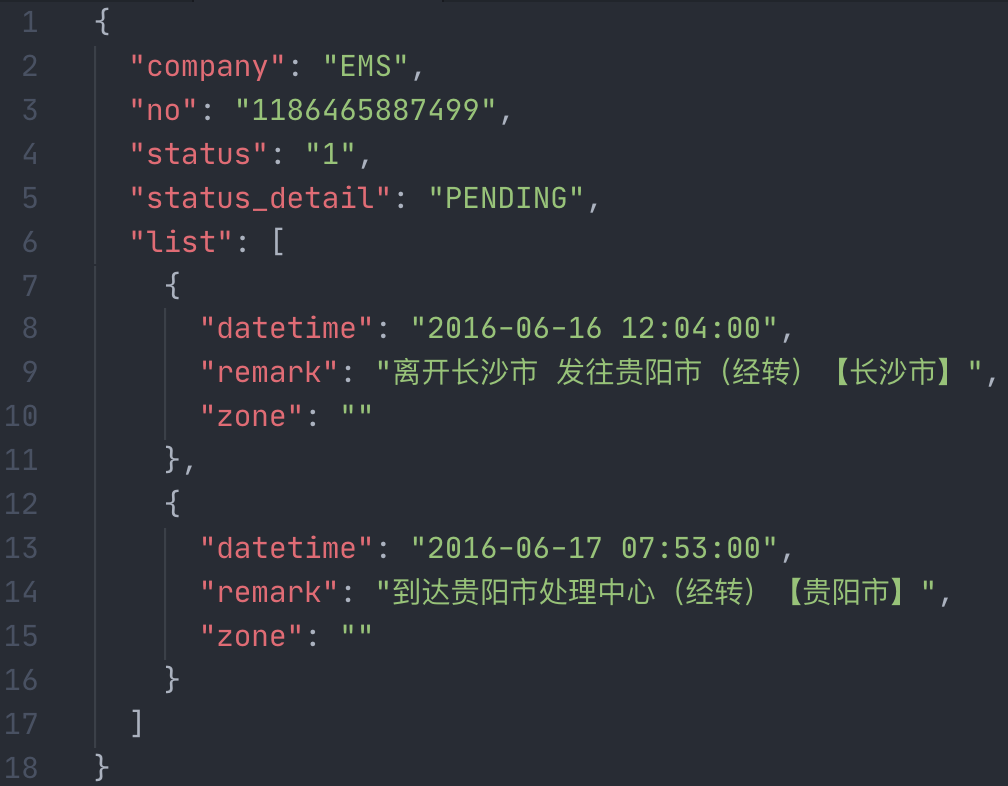

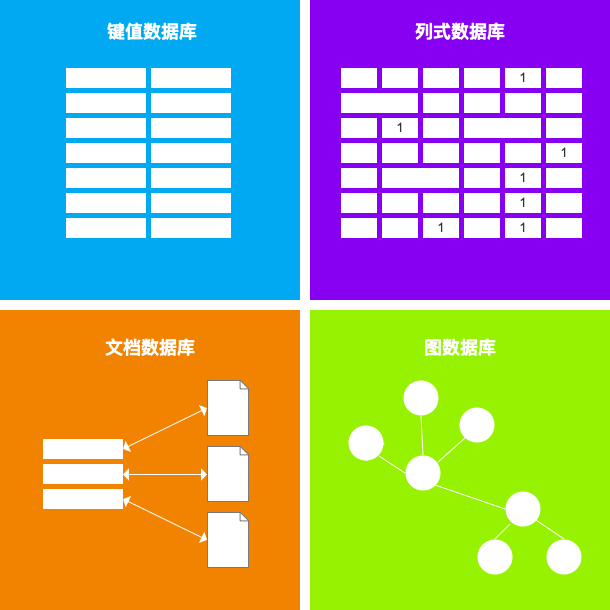

但是大数据量的情况就不同了。首先,数据量可能会大到用普通关系型数据库分表的方式都没办法存储,只能存在大数据库中,以前的文章中提到,NoSQL 的列式数据库适合存储大数据,如 HBase,这类数据库对 SQL 支持并不如关系型数据库那么良好。其次,复杂 SQL 语句或特定 SQL 语法在这类数据库里执行效率非常差,可能数十分钟,甚至小时级才能返回结果,或者干脆查不出来。

这就与即席查询的理念不符。用户所面临的问题是,查询所需的基础数据都已存储在物理数据库里,但查询耗时太长,不能满足查询时效的要求。

为了解决这个问题,诞生了很多即席查询的引擎。如 Impala、Presto、Druid、Doris、ClickHouse 等。

它们的技术原理也很简单,比如增加热点数据的缓存、优化数据分区、预计算、内存计算、并行计算等,达到加快获得查询结果的目的。

4、分析

这里主要指多维分析,即 OLAP。数据分析可以说是最常见、最直接的数据业务,我们每个人或多或少地做过一些数据分析的工作。

基于统计学的数据分析,核心就是确定维度、指标、度量。多维分析,强调的是分析的灵活性。

从维度的角度来说,不同类型的维度值,有稳定不变的、缓慢增长的、急剧变化的;维度的层级和粒度,可以向上汇总、向下细分,即术语所说的上卷、下钻;从维度度量的组合、裁剪来说,借助数据立方体的模型,可以有切片、切块、旋转等操作。

度量,常见是那些聚合操作,求和、最小值、最大值、平均值、总数等。

指标,如人口数量、销量、及格率等,有的是数据库表中的一个已有的字段,称为原子指标,意思是不可再拆分,利用原子指标再计算得到的指标,称为派生指标。

数据分析,就是在玩维度、指标和度量,核心工作在于构建这三者组成的数据模型。

很多人分不清即席查询和多维分析的区别。多维分析始终围绕着数据建模,原始数据为了适应新模型,需要有数据融合、多表关联、指标定义加工等工作;即席查询,更多是通过查询获得一个值、一条数据或一批数据。在数据规模大的情况下,多维分析同样存在像即席查询的性能问题。

出于建模的需要,OLAP 常常和数据仓库紧密衔接。数据仓库的明细层、汇总层、公共维表层等,经常是为了 OLAP 的分析目标去构建模型。

现在常说的智能数据分析,是提取数据集里数据的特征,判断其连续性,偏离散的,自动识别为维度,偏连续的,识别为度量。自动生成事实表,再智能挑选合适的图表类型(折线图、柱状图、饼图等)表现出来。

5、可视化

数据可视化,也是较常见的数据业务。通过图表的方式,可更直观地表达数据的含义和数据之间的关系。分为 BI 可视化和大屏。

这里的 BI,是狭义的 BI,主要是指借助 BI 工具,去完成数据的可视化表达。更广义的 BI,是通过数据挖掘产生商业智能决策的依据,可进行规律探索、趋势发现和商业洞察。

一个好用的 BI 工具,支持快速选择和拖动维度和度量字段,生成恰当的数据透视表。可灵活地完成多维分析中提到的维度、度量、指标三者的定义和转换等。

现在某些厂商的 BI 产品,已经向着智能问答式的交互方向发展,对着系统说出分析的需求,如“某地区产品销量环比”,系统就能自动从相关数据集中获取维度与度量,智能生成透视表。

大屏,也是近年来较常见的数据需求,基于统计分析和监控告警的仪表盘(DashBoard)和领导驾驶舱,如天猫双十一销售统计大屏。

政府机构对大屏有比较广泛的需求,原因是数据大屏是展示数据建设工程成果比较好的方式。

为了快速生成大屏,也有相应的产品支撑,如阿里云的 DataV。这种产品可以自由地设定画布大小,灵活布局。可视化组件拖放到画布上,设置好所连接的数据源和更新频率,即可直接查询数据库或通过 API 请求所需数据。用户可以在很短时间内,配置出非常炫的大屏。

6、画像

我们常听到的用户画像,是从用户数据中提取用户特征,包含生理、社会属性,以及行为习惯的特征,以此精细刻画用户——甚至比他对自己的了解更深入。另外也可以根据相同的特征选取同一用户群体——这个操作称为用户圈层,接下来就可以针对性地对这类用户实施影响策略。

实际上,不只用户可以画像,一切实体均可画像。

画像背后的核心,是一套标签体系。标签可以是人工或程序产生。给数据打标签,有的简单,经过常规计算就能完成,有的则需要机器学习算法参与。

人工参与打部分标签,类似监督学习;无人干预,类似于无监督学习,算法自动找出数据规律,贴上正确的标签。

比如,出生地、80 后这种标签,根据字段值就能直接获得,有些则需要经过简单的计算。

另外一些就比较复杂。比如人的自然性别只有男女两种,购物性别则不然,男性在购买特定品类也会呈现出不同程度的女性心理,反之亦然,所以,淘宝的购物性别标签,据说有近 20 种。

这样一来,在导购设计、商品推荐和活动运营中,对不同品类和用户就可以有不同的策略设计。

7、广告

营销领域中,广告主最在意的就是效果和成本。为了服务好广告主,广告平台通过大数据不断优化广告内容、渠道和人群的匹配,实现效果营销和精准投放的目的。

这是三赢的局面,平台推送给用户的广告精准,一方面广告主高投入产出比达到了营销目的,也就更愿意选择这样优质的平台,另一方面,用户也不会受到太大的干扰。

精准投放和上面的画像应用密切相关,除此以外还包含更多的分析应用。

首先在投放层面需要有基础数据,包括用户画像、广告物料画像、渠道画像、三者的关联数据和生命周期数据等,算法不断调整它们的匹配度,给出投放建议。

在效果评估层面,有到达、转化的漏斗模型统计分析。这里有基于埋点日志的实时统计分析方法,去统计曝光率、事件交互等。

日志分析也是大数据的重要细分领域之一,有专门的大数据组件完成日志的采集,如 Flume、LogStash。配合实时计算引擎,如 Flink,完成一些实时分析统计。

至于我们搜索后在其它产品中出现相关广告,或者说过一句话,就在某产品中就出现了应答广告。原因是在技术上,系统确定了我们的唯一用户身份,并通过广告联盟平台进行了数据共享。

很多网站和应用上出现的广告,并不是它自身投放的。它作为一个流量主,注册成为了广告平台上的一个渠道。当广告平台获取到你的用户身份和行为,它就能把匹配到的广告投放到能触达你的每一个渠道。

如你在百度上完成了一次搜索,百度的广告平台就能获取到你的用户标识和搜索关键词,把匹配好的广告,自动投放到你使用的其它应用上,这样你就感觉在一段时间里,相同的广告包围了你。

APP 偷听也是同样的道理,某个 APP 获得手机麦克风的使用权限,如果它不尊重用户隐私,就会滥用权限,就可能把它匹配出来的广告通过广告联盟分发到其它 APP 上。

大部分 APP 还会读取剪贴板,获取我们复制的内容,用于广告或其它目的。目前大部分移动操作系统还都没有对剪贴板的权限进行管控。

8、风控

在工业和金融领域,对风控有很高的要求。需要基于规则模型处理大量数据,且实时性非常强。

工业方面,主要有设备故障监测告警、预警。在传感器产生的时序数据中,要能及时地发现异常波动,包含频率、周期的异常及其它离群值高的数据,结合上下游设备和环境的数据,定位风险,实时暴露。

金融安全方面,有针对贷款业务的征信数据分析,也有对异常交易行为的快速处置。如发生一笔信用卡刷卡业务,产生了一条交易数据,会立即触发上百条规则去校验是否存在盗刷、套现等恶意行为。这些规则包含对商户、POS 机、持卡人、交易额度、时间、频率非常多交叉的判断。

除此以外,谋求黑产利益的羊毛党,对电商、O2O 业务也存在很大的挑战,商品限购、代金券优惠券发放的业务,都存在被刷的风险。除了在业务代码逻辑上防范这些风险,还要有基于数据实时分析的风控保障,疑似恶意的行为被及时感知并告警。误报、漏报之间的平衡,是技术细节的难点。

风控模型和规则引擎,是大数据风控业务的核心技术。

9、推荐

我们的生活已经被算法推荐包围了。拥有头条、抖音现象级产品的字节跳动公司的估值,也已超过了百度的市值。

推荐是大数据应用很重要的一个方向,目前已成效显著。可分为信息流推荐和商品推荐。

信息流推荐就是新闻、视频等内容推荐。根据我们点击、查看的记录,系统会不断学习识别我们的偏好,把相似内容不断地推送到眼前,让我们沉浸其中。

商品推荐一方面是根据我们的行为,如搜索、浏览、收藏、加购物车等进行推荐,另一方面是推荐同一类型画像用户购买的商品,这样会提高用户的下单率。

“千人千面”是这一业务的核心挑战,想想看,亿级用户个性化的推荐清单,都要随着用户行为变化而更新和排序,还要把已购商品从清单中去除,光是这项工作,就非常复杂了。

总结

立足于数据本身所能做的事情,我们总结出上述九大类业务。如果将数据和 AI 人工智能算法结合,数据作为燃料,算法作为引擎,还能展开更多的智能化业务,就不在本文的讨论范围内了。

可以说,这九大类的数据业务,足以涵盖目前及未来几年内的数据业务需求,数据产品经理可牢记心中。我们设想数据能发挥什么价值时,可以从这九类里寻找答案,获得启发。

这九大类数据业务,从上到下依次是从传统到现代、从离线到实时的变化特点,每个类别重点所需的大数据处理技术也不相同,有的重数据集成,有的重数据治理,有的重数据计算,越靠后的业务对大数据实时计算的要求越高。

在以后的文章中,我们逐步来了解每一项技术。

以上是「关耳爷」对大数据业务的一点小总结,请笑纳。